AI 패권 경쟁은 이제 기업 간 경쟁을 넘어 국가 간 경쟁으로 확대되고 있다. 우리는 지금, AI와 인간이 서로 공존하고 협업하며 새로운 가치를 창출하는 초지능(superintelligence) 사회를 살아가고 있다. 4차 산업혁명이 디지털화, 데이터 기반 의사결정, 그리고 AI를 포함한 가상 융합기술을 구현하는 데 집중했다면, 지금은 이를 바탕으로 더 효과적이고 지속 가능한 사회를 실현하는 데 관심을 두고 있다. 이러한 흐름은 지난 6월 4일, 새롭게 출범한 이재명 정부의 대선 공약에서도 찾아볼 수 있다. 공약에서는 AI 성장을 국가 경제의 핵심 성장 동력으로 삼는 동시에, 미래세대를 위한 기후 대응 등 친환경 의지가 담겨있다. 특히 AI 공약의 실행 방안으로 AI 100조 원 규모의 투자와 데이터센터 건립이 포함되었는데, 이는 AI 기술의 급격한 발전과 서비스 이용 확산을 안정적으로 뒷받침하기 위한 기반 시설 확보 차원에서 매우 중요한 의미가 있다.

데이터센터는 단지 대량의 데이터를 저장하고 보관하는 설비 시설을 넘어, AI와 인간이 조화롭게 살아갈 생태계를 작동시키는 필수 기반 시설로 자리 잡고 있다. AI 데이터센터는 주변 환경 및 지역사회와 공존하며, 에너지 소비, 물 사용, 온실가스 배출 등 환경적 영향을 고려해 지속 가능한 선순환적 인프라 구축은 필수적이다. 이제 AI 분야는 기술 중심 확장을 지나, 지역사회와 상생하고 환경적 책임까지 포괄하는 인간 중심의 새로운 패러다임으로 전환되고 있다.

1

데이터센터와 환경자원

AI는 데이터 처리량과 비례해 상당히 많은 양의 전기와 물을 소비해야 한다. AI 기반의 개별 쿼리(query), 즉 단일 정보의 조회나 검색을 요청하는 것은 단순해 보일 수 있지만, 한 단위의 지역, 도시, 혹은 국가에서 동시에 이뤄지는 수많은 요청을 누적하고 처리하려면 상당히 많은 자원의 소비가 필요하다. 전 세계 수십억에 이르는 정보를 축적, 요청, 처리를 위해 데이터센터는 환경적인 부담을 초래할 수밖에 없는 구조이다.

특히 대형 언어 모델(LLM)은 학습(training)과 추론(inference) 과정에서 모두 대규모 전력과 냉각용 물이 필요하다. 이러한 자원의 소비는 AI 서비스 이용이 확산하면서 기하급수적으로 증가하고 있으며, 비용뿐만 아니라 탄소 발생과 같은 환경문제와도 맞닿아 있다. 미국 캘리포니아대학교 리버시이드(UC Riverside) 연구에 따르면, GPT-3 훈련에는 약 70만 리터의 물이 소모되었는데, 이는 자동차 약 300대 생산에 필요한 물의 양과 비슷한 수준이다.

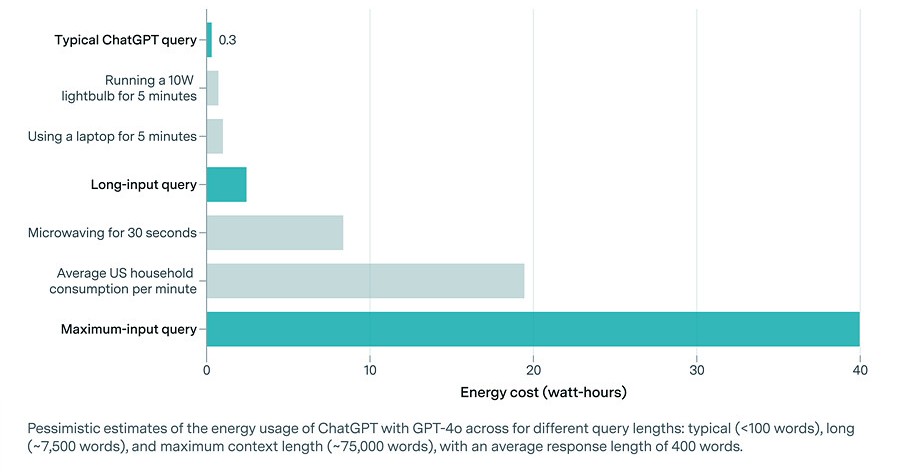

또한 AI 전문 연구소 에포크AI(Epoch AI) 분석에 따르면, 일반적인 ChatGPT 쿼리 하나당 약 0.3Wh(와트시)의 전력이 소모되며, 오픈AI(OpenAI) CEO 샘 알트만(Sam Altman)도 공식적으로 쿼리 하나당 평균 0.34Wh라고 밝힌 바가 있다. 이 전력량은 오븐을 1초간 작동시키거나, 고효율 LED 전구를 몇 분간 켜는 수준이다. 하지만, 이 수치는 2009년 구글(Google)이 자사의 데이터센터 에너지 효율성과 관련해 발표한 자료를 바탕으로 추정된 것이다. 당시 구글은 “검색 한 건당 약 0.3Wh의 전력이 소비된다”고 밝혔는데, 이는 지금과는 기술 환경이나 인프라 구조가 크게 다른 시점의 데이터로, 현재의 AI 시스템과 직접 비교하기에는 한계가 있다. 에포크AI에서도 입력 시간이 긴 쿼리, GUP 전력 소비, 입력토큰 에너지 등을 고려하면 전력 소비량은 크게 달라진다고 밝혔다. 실제로 GPT-3 훈련에서 약 1,287MWh(밀리와트시), GPT-4 훈련은 약 52~62GWh(기가와트시) 전력으로 GPT-3 대비 약 40~48배 이상 엄청난 수치로 증가했다.

그림 1. AI 전력 소비량 / 출처 : Epoch AI (2025. 2. 7).

이처럼 LLM은 학습 시 수십만 리터에 이르는 물, 추론 시 쿼리당 수백 밀리와트시(MWh), 또는 기가와트시(GWh) 전력을 소비한다. 특히 AI 기반 대규모 서비스로 확장할 경우, 이 소비량은 도시나 국가 단위로 늘어나서 전략과 수자원에 상당한 부담을 안겨줄 수 있다. 이러한 점에서 환경적 영향을 고려한 지속 가능한 AI 발전 계획과 설계가 필요하며, 이를 위해 친환경 인프라 설계, 재생에너지 등 도입을 실행하고 있다.

AI 선도자인 미국에서 데이터센터의 전력 소비는 폴란드 전체 전력 사용량과 유사한 수준으로 알려졌고, 2026년까지 전 세계 데이터센터 전력 수요는 2배 이상 증가할 전망이다. 미국에서 건설 중인 1,240개 데이터센터 중 약 40%는 물가와 인접한 지역에 있으며, 하루 수백만 갤런의 물을 사용한다. 이런 점에서 데이터센터로 인한 환경과 공공보건 등과 관련된 영향과 추가적 비용도 늘어날 것으로 보인다. 따라서 AI 데이터센터는 지속 가능성을 염두해, 환경 영향의 투명한 측정, 효율적 인프라 설계, 재생 에너지 및 수자원 재활용 시스템을 고려한 체계적인 설계가 필요하다.

1

데이터센터 사례

해외에서는 구글, 아마존, 오라클 등 주요 소프트웨어 기업들이 SaaS(Software as a Service) 형태의 클라우드 컴퓨팅 기반 소프트웨어 서비스를 선도적으로 도입하며, 이미 자사 운영을 위한 대규모 데이터센터를 구축하고 이를 직접 관리해 오고 있다. 이들 기업은 안정적이고 확장할 수 있는 기반을 기반으로 글로벌시장에 클라우드 서비스를 제공하고 있으며, 동시에 AI, 빅데이터, IoT 등 차세대 기술 플랫폼으로서 서비스 확장과 AI 혁신을 위해 데이터센터의 전략적 중요성을 점점 더 강화하고 있다.

최근 AI 기술의 급격한 발전과 이용률 증가에 따라, 데이터센터의 구축과 운영은 환경적 지속 가능성과 지역사회와 조화를 함께 고려한 선순환 구조로 설계하는 것이 핵심 과제로 부상하고 있다. 이는 단순한 기술 진보를 넘어, 환경과 기술이 조화롭게 공존하는 새로운 산업 패러다임으로의 전환을 의미한다.

1

1) 구글(Google) 데이터센터

구글은 2000년대 초부터 자체 데이터센터를 구축했고, 현재 전 세계에 수십 개의 하이퍼스케일 센터를 운영 중이다. 2003년 조지아주에 첫 데이터센터를 가동했는데, 공개된 자료는 없지만 2016년 기준 가트너 발표에 따르면 약 250만 대 서버를 운영한 것으로 추정되며 현재는 그보다 훨씬 더 많은 서버를 운영 중인 것으로 추측된다. 2023년 구글 데이터센터는 연간 24TWh(테라와트시)의 전력을 사용하며, 전 세계 데이터센터 소비 전력의 7~10%를 차지할 정도로 규모가 크다.

구글은 2017년부터 100% 재생에너지 구매를 실현했으며, 2030년까지 24시간 무탄소 전력 운영을 목표하고 있다. 전력사용효율(PUE)은 평균 1.10으로 업계 최고 수준이며, AI 기반 냉각 제어 시스템을 통해 에너지 사용을 지속해서 최적화하고 있다. 딥마인드를 활용한 냉각 최적화로 냉각 에너지 40% 절감에 성공했고, 물 사용 최적화도 함께 진행 중이다. 또한 자체 개발한 TPU(Tensor Processing Unit, 구글에서 2016년 5월에 발표한 머신러닝을 위해 설계된 ASIC. 대규모 행렬 연산에 특화되어 있다) 칩 기반 AI 슈퍼컴퓨터를 운용 중이며, 수랭식 냉각을 적용한 고밀도 클러스터를 통해 PaLM(Pathways Language Model, 구글 AI에서 개발한 5,400억 개의 파라미터 변환기 기반 대규모 언어 모델) 등 초거대 언어모델을 훈련하고 있다. AI 수요 증가에 대응해 클라우드 확대와 함께 1.6GW 규모의 재생에너지 PPA(Power Purchase Agreement, 전력수급계약 또는 전력구매계약이라 불리며, 발전사업자와 송배전사업자, 전력소비자 간에 구입 기간을 정하여 체결하는 전력 구입에 관한 계약을 의미)를 체결했고, Vertex AI 등 AI 클라우드 서비스를 통해 외부 고객도 지원 중이다. AI 기반 자원 배치, 고밀도 전력공급 기술 등으로 고효율 AI 워크로드 환경을 조성하고 있다. 이와 함께 전력 소모와 온실가스 배출도 증가하고 있으나, 구글은 재생에너지 확대 및 기술 혁신으로 지속가능성 목표를 병행 추진하고 있다.

1

2) 아마존 데이터센터

아마존 웹 서비스(Amazon Web Services, AWS)는 2006년 상용 클라우드 서비스를 시작하며 미국 버지니아에 첫 데이터센터를 구축했다. 아마존은 현재 전 세계 22개 지역에서 수백 개의 데이터센터를 운영 중이며, 각 지역은 최소 3개 이상의 가용영역(AZ)을 갖췄고, 전체 센터 수는 100개 이상으로 추정된다. 서버 대수는 공개되지 않았으나 수백만 대 수준으로 평가된다. 울산에 설립 예정인 데이터센터는 초기 103MW 규모와 GPU 6만 장을 갖춘 아시아 최대급 AI 허브로 계획 중이다.

AWS는 2023년 평균 PUE 1.15(최고 1.04) 수준으로, 고효율 표준화 설계와 글로벌 최적화를 통해 업계 최고 수준의 에너지 효율을 유지하고 있다. 2019년 ‘2030년까지 재생에너지 100% 전환’을 목표로 했으나, 이를 앞당겨 2023년에 모든 운영 전력을 재생에너지로 매칭했다. 현재 전 세계 27개국에서 총 28GW 규모의 재생에너지 프로젝트를 운영 중이다. 데이터센터 설계에서도 저탄소 자재 사용, 수처리 기술, 재활용수 및 빗물 활용 등 지속가능성을 실현하고 있다.

AWS는 AI 시대에 대응해 자체 AI 칩(Inferentia, Trainium) 개발 및 배치를 통해 초거대 연산을 지원한다. AI 수요 확대에 맞춰 데이터센터 아키텍처도 랙당 전력공급을 6배 이상 강화하고, 머신러닝 기반 자원 최적화로 연산 효율과 친환경 효과를 동시에 추구하고 있다. 대표적 사례로, 울산에 구축될 센터는 GPU 6만 장과 100MW+ 전력을 갖추고 초거대 모델 학습과 서비스의 거점이 될 전망이다. AWS는 높은 가용성과 신뢰성(99.9999%) 확보를 목표로 데이터센터의 구조를 지속 혁신하고 있다.

1

3) 네이버 데이터센터

네이버는 데이터센터 각(Gak)을 춘천, 세종, 글로벌로 확장하고 있다. 2013년 국내 인터넷 기업 최초로 강원도 춘천에 자체 데이터센터 ‘각 춘천’을 설립하며 인프라 자립을 시작했다. 각 춘천은 연면적 약 46,850㎡ 규모로, 서버 약 10만 대를 수용하며 10년 이상 무중단 운영에 성공한 대표 사례다. 이후 2023년에는 세종시에 두 번째 센터 ‘각 세종’을 개관했으며, 부지 면적은 29만 4천㎡로, 최대 60만 대 서버와 270MW 전력 수용이 가능한 하이퍼스케일 데이터센터로 설계했다. 또한 글로벌 주요 10개 지역 인프라 거점을 연결한 네트워크를 보유하고 350여 개 로컬 통신사와 함께 클라우드 서비스를 제공하는 ‘각 글로벌’을 확장 중이다.

네이버는 친환경 설계 철학을 바탕으로 데이터센터를 구축했다. 각 춘천은 연평균 기온이 낮은 지역 특성을 활용한 자체 공조시스템 ‘NAMU’를 도입하여 외기냉방을 극대화하고, 폐열을 도로 제설 및 온실 난방 등에 재활용했다. 이를 통해 LEED 플래티넘 인증과 최고 점수를 획득했으며, 2040년까지 RE100을 달성하겠다는 목표도 세웠다. 각 세종에는 3세대 NAMU 시스템을 적용하여 계절별 기후에 최적화된 냉방을 구현하고, 진도 9.0 대응 내진 설계, 플라이휠 UPS 등 안정성과 친환경을 모두 갖춘 구조로 완성됐다.

AI 인프라 측면에서, 네이버는 하이퍼클로바(HyperCLOVA)와 하이퍼클로바 엑스(HyperCLOVA X)와 같은 초거대 언어모델을 자체 데이터센터에서 직접 훈련하고 서비스한다. 이를 위해 국내 최대 GPU 클러스터를 각 세종에 구축하고, AI 전용 서버를 대규모로 운영 중이다. 또한 자율주행 로봇 ‘가로’, 로봇팔 ‘세로’ 등 AI·로보틱스 기술을 활용한 자동화된 운영 시스템을 도입해 운영 효율과 정밀도를 동시에 높였다. 이 기술은 사우디 등 해외에 수출도 추진 중이다. 네이버는 이러한 초거대 AI 인프라를 바탕으로 AI 클라우드 서비스도 외부 기업에 개방하고 있으며, 국내 스타트업과 콘텐츠 기업들이 고성능 연산자원을 손쉽게 활용할 수 있는 환경을 조성하고 있다.

1

4) 카카오 데이터센터

카카오는 2022년 SK C&C 판교 데이터센터 화재를 계기로, 자체 데이터센터 구축의 필요성을 더욱 절감했다. 실제로 카카오는 2021년부터 자체 데이터센터를 준비해왔고, 2023년 경기도 안산에 첫 하이퍼스케일 센터를 완공해 가동 중이다. 한양대 캠퍼스 내에 조성된 이 센터는 연면적 약 3만㎡, 서버 12만 대, 저장용량 6EB, 전력 40MW 규모로, 주로 카카오톡 등 핵심 서비스의 안정적 운영을 맡고 있다. 이후 2028년 완공 예정인 제2데이터센터는 남양주에 위치하며, 안산의 2배인 80MW 전력 용량을 갖춘 초대형 AI 전용 센터로 조성된다. 이 센터는 고집적 GPU 및 AI 가속기를 수용해 초거대 AI 모델 학습·추론을 지원하고, 카카오브레인과 카카오엔터프라이즈의 AI 서비스 인프라가 될 예정이다.

카카오 데이터센터는 친환경적 데이터센터 설계가 인상적이다. 안산센터는 녹색건축인증, 에너지 효율 1등급을 목표로 태양광, 고효율 냉방, 물 재활용 시스템 등을 적용했다. 또한 한양대와 산학협력, 인재 양성 프로그램을 운영해 지역 혁신 거점으로 기능하고 있다. 향후 남양주 센터도 친환경·스마트 인프라로 조성될 전망이다. 또한 카카오는 안산 센터에 전력 이원화, 이중화 통신망, 상시 백업 체계를 도입해 재난 대응을 보완하고, 향후 다중 센터 간 트래픽 분산(Active-Active) 구조를 추진해 서비스 연속성을 강화하고 있다.

카카오는 최근 AI 챗봇 ‘카카오 AI 메이트’, GPT 기반 모델(KoGPT), 이미지 생성 AI(minDALL-E) 등 AI 서비스 확대에 따라 연산 인프라 확보에 속도를 내고 있으며, AI 클라우드 사업(Kakao i Cloud) 확대와 함께 B2B 시장 진출을 모색 중이다. 향후 AI 기반 자동화 운영, 로봇 도입 등 스마트 데이터센터 기술 적용도 예상된다.

1

AI 데이터센터 설계 방향

AI 데이터센터 설계에서 지속 가능성과 지역의 조화가 핵심이며, 환경적 영향을 고려한 선순환 구조로 이어져야 한다. 특히 국가 전략 차원에서 AI 데이터센터를 설계한다면, 거시적 차원에서는 국가 경제를, 미시적 차원에서 지역 균형을 고려해 비수도권 거점에 데이터센터를 분산해서 수도권 전력 과밀 문제를 완화할 수 있다. 실제로 정부는 광주, 부산, 전북 등에 AI 인프라 구축을 계획 중이며, 얼마 전 울산시에서는 SKT와 AWS가 협력한 103MW, 7조 원 투자 규모의 국내 최대 AI 데이터센터가 착공식을 진행한 바 있다.

데이터센터는 지역 환경과 높은 상호 의존성을 갖기 때문에, 현지 재생에너지 인프라와 연계성을 고려한 설계가 요구된다. 이는 단순히 전력망에 부하를 주는 것이 아니라, 신재생에너지 투자를 유도하고 지역 에너지 생태계에 기여하는 방식이 되어야 한다. 또한, 데이터센터에서 대량으로 발생하는 폐열은 인근 지역의 난방, 온수 공급 등에 재활용할 수도 있는데, 북유럽 국가들처럼 지역난방공사와 협력해 폐열 활용 시스템을 통해 탄소를 줄이는 방법도 고려해 볼 수 있다. 또한 데이터센터 내 빗물이나 중수 재이용 설비를 갖추고, 수자원 사용량을 실시간 모니터링해 지역 생태계에 영향을 주지 않도록 관리해야 한다. 아울러, 데이터센터로 인한 전력 소비와 토지 이용에 따른 지역사회의 우려를 해소하려면, 정보의 투명한 공개와 주민 협의, 지역 환원을 위한 구체적 프로그램이 필수적이다.

데이터센터는 지역대학 및 연구기관과 연계해 산학 협력 생태계를 조성함으로써 지역 인재 유출을 막고 지역 혁신 거점으로 기능할 수 있다. 네이버의 춘천 사례나 카카오의 안산 센터처럼, 인근 대학과 연구소를 유치해 공동 연구 및 인턴십 프로그램을 운영하면 AI 인재 양성과 활용의 선순환 구조를 만들 수 있다.

AI 데이터센터는 단순한 IT 인프라를 넘어, AI 시대 국가 경쟁력을 좌우하는 핵심 자산이다. 한국형 데이터센터 모델은 글로벌 선도 기업의 친환경 전략과 국내 기업의 지역 밀착형 운영 경험을 결합해, 탄소발자국을 최소화하면서도 지역과 공존하는 지속 가능한 생태계로 발전해야 한다.

1

AI 데이터센터와 방송·미디어의 창의적 시너지

AI 데이터센터는 방송·미디어 산업과 융합을 통해 창의적이고 전략적인 시너지를 창출할 수 있는 핵심 인프라가 될 수 있다. 특히 초고속·고용량 연산이 필요한 콘텐츠 산업에서 AI 연산자원을 클라우드 형태로 제공함으로써, 중소 미디어 기업부터 대형 방송사, OTT, 게임사까지 AI 기반의 창작 생태계를 마련할 수 있을 것이다. 정부에서는 산업 수요에 맞춰, 콘텐츠 기업을 대상으로 한 클라우드 크레딧 지원, 공공 AI API(자연어 처리, 영상 인식 등) 무료 제공 프로그램을 통해 AI 도입 문턱을 낮추고 맞춤형 AI 서비스 포트폴리오를 개발하는 등 실질적인 지원을 통해 방송·미디어 산업의 AI 시너지를 촉진해야 한다.

또한 AI와 미디어의 융합 과정에서는 저작권·초상권·편집권 등 다양한 권리문제가 필연적으로 발생할 수 있으므로, 정부는 이에 대응하는 법·제도적 가이드라인과 윤리 기준을 조속히 마련해야 한다. 특히 생성형 AI가 기존 저작물을 학습하거나 새로운 콘텐츠를 생성할 때, 어떤 권리 구조와 활용 조건이 적용되는지에 대한 명확한 기준이 필요하다. 이를 통해 기업과 창작자 모두가 안정적이고 신뢰할 수 있는 환경에서 AI를 활용할 수 있도록 해야 한다.

이러한 데이터 인프라와 제도적 기반이 마련된다면, 방송·미디어 산업은 AI 기술과 결합해 창작의 경계를 확장하고 기술 도입에 따른 비용 부담을 줄일 수 있다. 국가 차원의 AI 데이터센터 투자가 단순한 인프라 구축을 넘어, K-콘텐츠와 디지털 기술이 융합된 새로운 혁신 생태계로 이어질 수 있도록 정책적 연계와 전략적 비전이 함께 수립되어야 한다.

1

참고문헌

・ 네이버 데이터센터 각(n.d.).

・ 이데일리(2025. 6. 22). SK·AWS, 울산에 7조 투자… 비수도권 첫 ‘AI 고속도로’ 열린다.

・ 전자신문(2025. 5. 14). 카카오, 두 배 큰 제2 데이터센터 남양주 낙점…하이퍼스케일로 구축

・ 카카오(2021. 12. 17). “빅데이터-AI-클라우드 중심 첨단 인프라 구축” 카카오, 데이터센터 착공식 개최.

・ Business Wire(2024. 12. 2). AWS Announces New Data Center Components to Support AI Innovation and Further Improve Energy Efficiency

・ Epoch AI(2025. 2. 7). How much energy does ChatGPT use?

・ Google data centers (n.d.).

・ TechRadar(2025. 5. 18). Microsoft, Google, and Meta have borrowed EV tech for the next big thing in data centers: 1MW watercooled racks.

・ The observer(2025. 6. 18). How much energy and water does AI use?

・ The Guardian(2016. 7. 20). Google uses AI to cut data centre energy use by 15%.

・ Time(2024. 6. 12). How AI Is Fueling a Boom in Data Centers and Energy Demand. Tech Artificial Intelligence.

・ Mckinsey&Company(2025. 6. 5). Data centers: The race to power AI