김승준 KBS 제작기술센터 TM

언택트 시대, 방송과 Metaverse의 접목은 콘텐츠 제작에서 화두가 된 지 오래다. KBS가 2021년 10월 하이브리드 Metaverse 개념을 방송에 새롭게 도입했다. 백악기 시대 공간을 대형 LED Wall로 표출하고 그 공간 속 공룡이 AR로 무대 위에 등장한다. Metaverse 공간에서 현실 스튜디오를 넘나들고 상호작용하며 지구의 탄생에서 화성시대까지 다양한 소재로 이야기를 이끌었다.

그간 XR 기술을 이용하여 현실에서 표현할 수 없는 공간을 만들어 뮤직비디오나 영화를 제작한 사례가 있었다. 하지만 이번 시도는 실제 방송국 스튜디오(Reality)와 가상공간(Metaverse)과의 Interaction을 이용한 방송 제작사례로 남을 것이며, 이는 우주를 향한 인류의 도전과 미래를 표현해내는 중요한 도구가 될 것이다.

이번 AR 작업은 메타버스 콘텐츠 제작사로 잘 알려진 비브스튜디오스에서 맡았다. 실시간 이벤트 방송에 필요한 소프트웨어와 하드웨어를 통합적으로 제어할 수있는 솔루션인 VIT를 사용하였다. 현장에서 월과 AR 등의 그래픽요소를 실시간 컨트롤하고 색조정을 할 수 있는 등의 기술력을 갖춘 운영시스템으로 효과적이었다. 이를 통해 1시간이 넘는 CGI씬들을 NG 없이 진행할 수 있었고, 이런 시스템을 갖춘다면 생방송도 무리 없겠다 싶었다. 물론 철저한 사전준비는 꼭 뒷받침되어야 할 것이다.

1

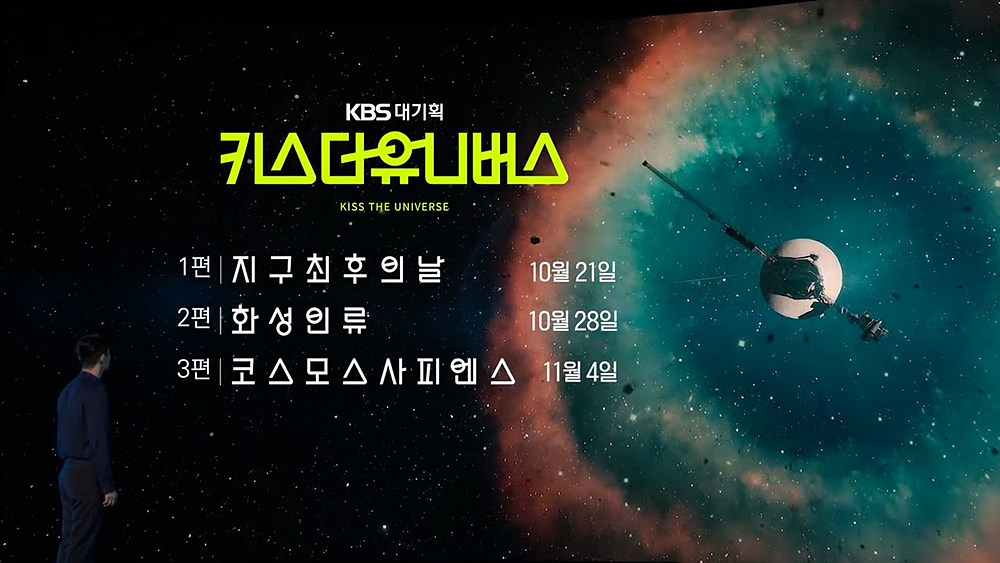

3부작으로 구성된 KBS 대기획 ‘키스더유니버스’의 제작 과정을 통해 방송에서의 Metaverse 활용에 대해 살펴보자.

1

1

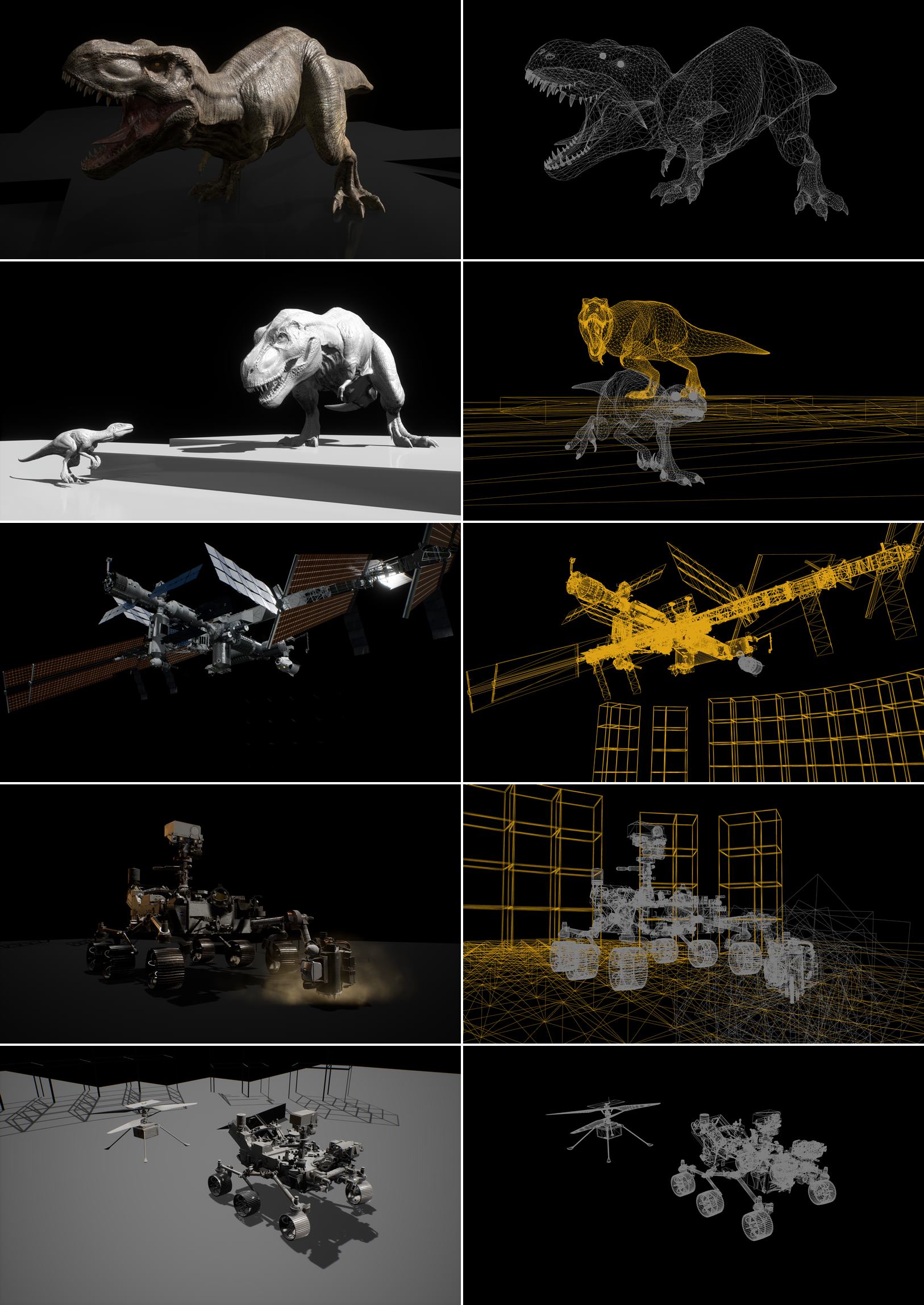

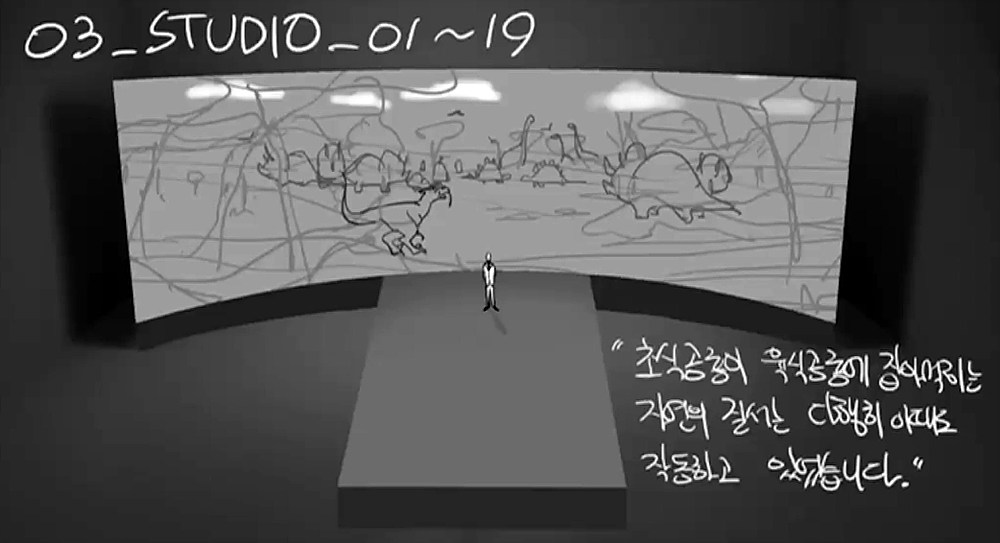

준비의 시기

보통 대기획 다큐멘터리는 오랜 사전 기획 단계가 선행된다. 하지만 VR/AR을 포함한 과학 다큐멘터리는 더욱더 치밀한 프리프로덕션(Pre-Production)이 필요했고, 그 안에는 기술적인 요소가 많이 포함되어 있었다. 가상공간(백악기 시대나 화성처럼 실제로 촬영하거나 구성하기 힘든 공간)을 VR이라는 기술로 LED 월에 표출시키고, 현실에 있는 스튜디오 공간으로 가상공간에 있던 티라노나 화성탐사로봇이 AR(증강현실) 기술로 LED 월에서 튀어나와 MC와 소통하는, 그런 영상이 기획되었다.

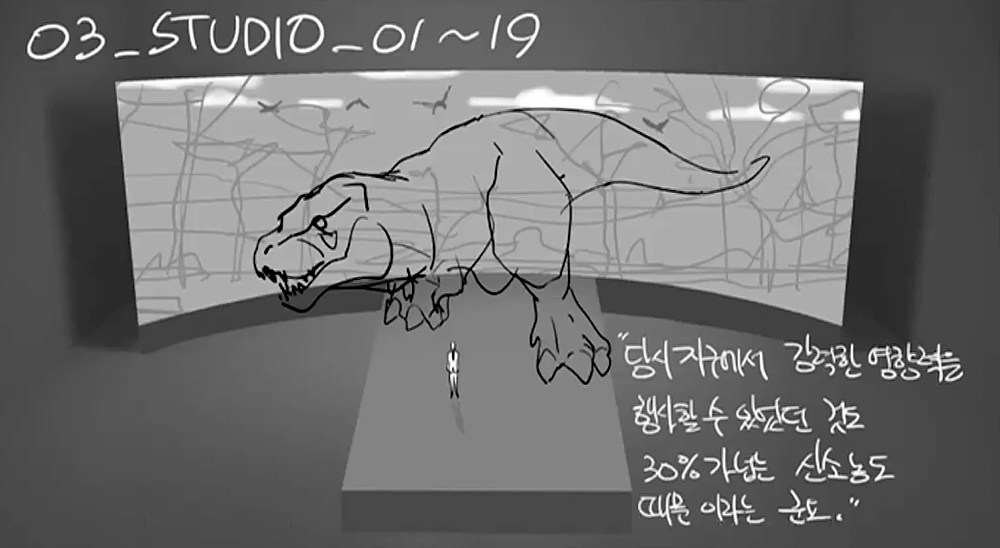

일반적으로 특수영상 씬은 콘티(conti)를 그리고 그에 필요한 미술이나 특수영상, 특수효과 등을 고려해서 현장에서 촬영 후 후반작업(Post-Prodution)을 진행하는 것이 통상적이다. 하지만 키스더유니버스를 준비하면서는 콘티 작업 부분을 단계별로 디테일하게 설계해야 했다. 그만큼 그래픽 디자인부터 애니메이션, AR/VR, 비디오월과 연동 등이 잘못 설계되었을 때 리스크가 컸기에 매순간 신중을 기했다. 컷별 RT(Running Time)를 연출 PD의 육성으로 내레이션을 직접 녹음하여 프리애니메이션에 올리는 작업까지도 진행했다.

1

1

1

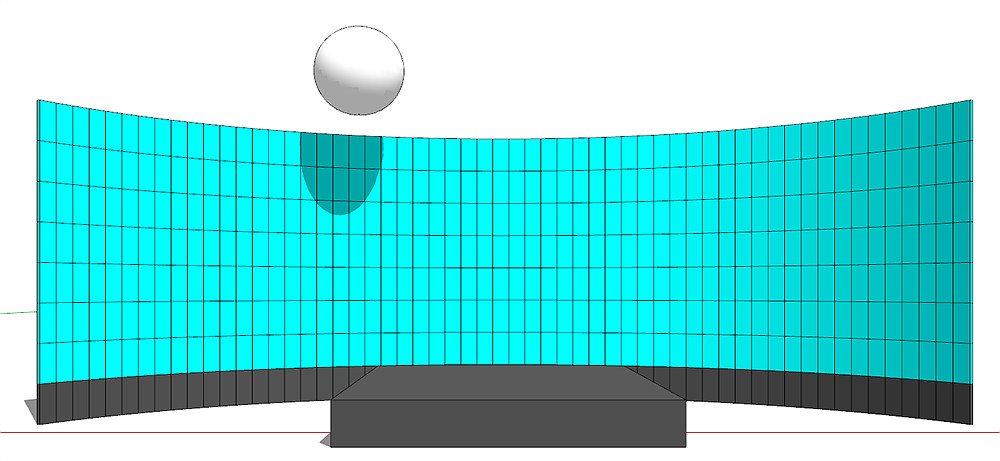

비디오월도 설계가 필요하다!

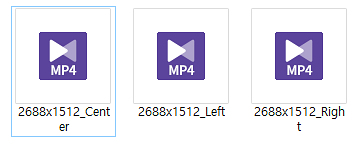

단순히 비디오월을 가로 몇 미터, 세로 몇 미터로 구성하는지만 미술감독(세트감독)님이 정해야 하는 사항은 아니다. 추가로 고려해야 할 사항이 N-Display(1대의 PC가 감당할 수 있는 해상도가 한계가 있으므로 비디오월 전체를 플레이하기 위한 병렬 PC 솔루션) 관련 해상도 분배, 도트피치(dot pitch : 비디오월 화면을 구성하는 점 사이 거리. 예) 2mm, 4mm 등)와 전체 구성 길이에 따른 전체 해상도, 그 해상도에 따른 영상 랜더링 사이즈 등을 계산하고 최적화하는 작업이 있어야 한다. 또한 AR을 위해서 필요한 워크스테이션의 구성, 카메라 트래킹 정보가 들어오는 것을 계산하고 뿌려주는 워크스테이션, 이 워크스테이션들의 네트워킹 등이 모든 고려 요소가 되므로, AR/VR 등이 실시간으로 현장에서 문제없이 구동되기 위해서는 고려해야 할 기술적 요소가 생각보다 많이 존재한다.

1

1

위기는 있었다. 본 방송은 2021년이었으나 2020년 가을 파일럿 콘텐츠를 제작해야 했다. 비디오월은 도트피치 4mm, 전체 크기는 약 가로 30m 세로 10m의 사이즈로 설계되었다. 도트피치가 비교적 넓은 제품인데다, UHD B4 마운트 렌즈 시스템은 모아레 현상을 야기하였다. 입자가 굵은데 해상도가 좋고 피사계심도가 깊은 조합이 영상 품질 저하의 원인이었던 셈이다.

또한, 바닥 LED 월을 설계하여 프리젠터가 지진 등의 상황에 리액션하고자 하였으나 의도만큼 효과적이지 못했다. 이 파일럿 제작 경험으로 본방송 녹화를 위한 기술적 설계를 업그레이드할 수 있었던 것으로 생각된다.

실시간 AR/VR을 위한 트래킹 기술

LED 월도 있고, AR/VR 용 그래픽 제작도 있지만, 그들을 정확히 실시간으로 현장 그림과 정합하는 기술 즉 트래킹 기술이 또한 중요했다. 지미짚의 암(ARM)의 각도와 줌 뭉치의 수치 팬/틸트의 수치, 베이스의 위치정보 등의 메타데이터 정보가 AR/VR을 연동하는 워크스테이션에 정확히 전달되어 화면이 뿌려져야 실시간 AR/VR 씬을 만들어 낼 수 있다. 말로는 간단한 것 같지만, 이 메타데이터의 추출에 있어 정확한 현장의 계측과 트래킹 장비의 셋업은 생각보다 시간이 많이 소요되며, 콘텐츠 제작의 중요한 워크플로우의 한 단계이다.

결국, 그래픽 퀄리티다

특수영상 VFX든 AR이든 VR이든 결국 콘텐츠를 시청함에 있어 중요한 요소는 그래픽 퀄리티임을 다시 한번 깨닫는다. 아무리 실시간 연동이 잘 되고, 중요한 내용의 씬이라도 그것을 시각적으로 표출해주는 티라노나 화성탐사로봇이 진짜와 비슷하지 않고 저퀄리티라면 그 씬은 기억에 남지 않을 것이다. 그 점에 있어 이번 ‘키스터유니버스’의 메인 크리쳐들은 디테일한 부분까지 퀄리티를 끌어올려 시청자들로 하여금 그 씬에 전달하고자 하는 내용을 정확히 전달하게 하고 시청 후에 강인한 인상을 심어준 1등 공신이었다.

1

1

실시간 이슈와 관객은 아직도 숙제?

‘키스더유니버스’는 당초 계획이 관객이 있는 스튜디오 녹화였다. 실시간으로 구현되는 AR/VR 그래픽을 관객들과 같이 호흡하며 즐기는 목표가 있었다. 이를 실현하기 위해 현장에 네트워크망을 구성하여 AR 글래스 or HUD or 스마트기기 등에 실시간으로 AR 그래픽 등을 전송해주는 솔루션을 구성해보고자 했었다. 하지만 코로나 19 거리두기 단계 악화로 관객 없는 녹화를 진행할 수밖에 없었다. 실시간 AR 그래픽을 관객들과 동시에 즐기며 녹화를 할 날이 위드코로나 시대를 벗어나면 올 것이고, 그를 위한 시스템 설계도 방송콘텐츠를 만드는 것만큼 고려해야할 것이다.

키스더유니버스 제작을 마치고

초등학교 2학년인 아들과 집에서 본방송을 시청하였다. 아빠가 만든 프로그램이라고 더욱 관심이 있던 터였다. 하지만 보는 60분 내내 눈을 떼지 못했고, 질문은 쏟아졌다. “운석이 정말 떨어져? 화성에 가서 살아야되는 거야?” 등 방송 내내 내가 프로그램을 하며 배운 지식을 나누며 가족들과 즐겁게 시청했다.

방송을 마치고 블로그 등에서 ‘초등과학의 바이블이다’라는 평이 있는 것을 보고, 아이를 키우는 한 부모로서, ‘키스더유니버스’에 참여했던 한 스태프로서 보람있었다. 어려운 기술을 방송에 접목을 굳이 해야 했나? 굳이 관객도 없는 콘텐츠를 실시간 그래픽으로 제작했어야 했나? 했던 작은 불만들은 머릿속에서 그렇게 사라졌다. 언제나 새로운 제작기술을 콘텐츠 제작현장에 소개하고 접목하는 일, 그것이 방송엔지니어로서의 소회이지 않나 생각해 본다.

![[인터뷰] 2025 방송기술대상 대 상 – MBC 안경찬](http://tech.kobeta.com/wp-content/uploads/2026/01/IMG_4459-238x178.jpg)